4.2.3文本数据处理 课件 2022—2023学年浙教版(2019)高中信息技术必修1(30张PPT)

文档属性

| 名称 | 4.2.3文本数据处理 课件 2022—2023学年浙教版(2019)高中信息技术必修1(30张PPT) |

|

|

| 格式 | pptx | ||

| 文件大小 | 5.3MB | ||

| 资源类型 | 教案 | ||

| 版本资源 | 浙教版(2019) | ||

| 科目 | 信息技术(信息科技) | ||

| 更新时间 | 2022-12-05 20:35:13 | ||

图片预览

文档简介

(共30张PPT)

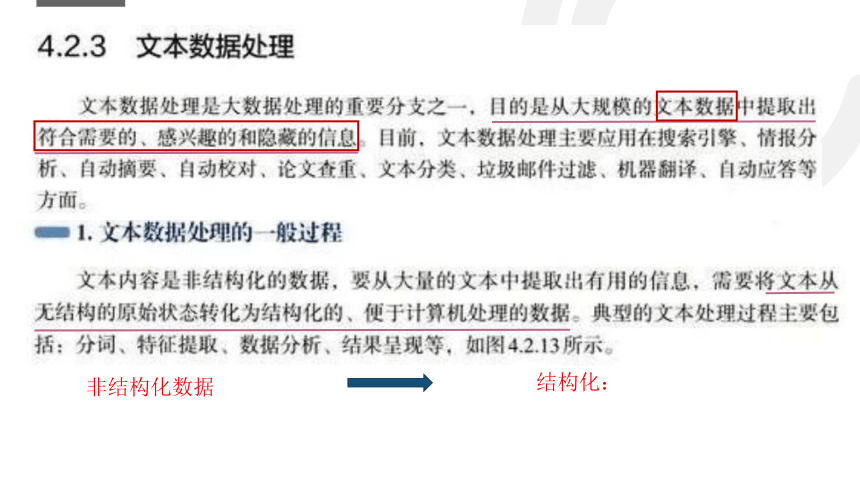

文本数据处理

百度搜索:信息技术难不难?

文

本

数

据

处

理

文本数据处理的应用

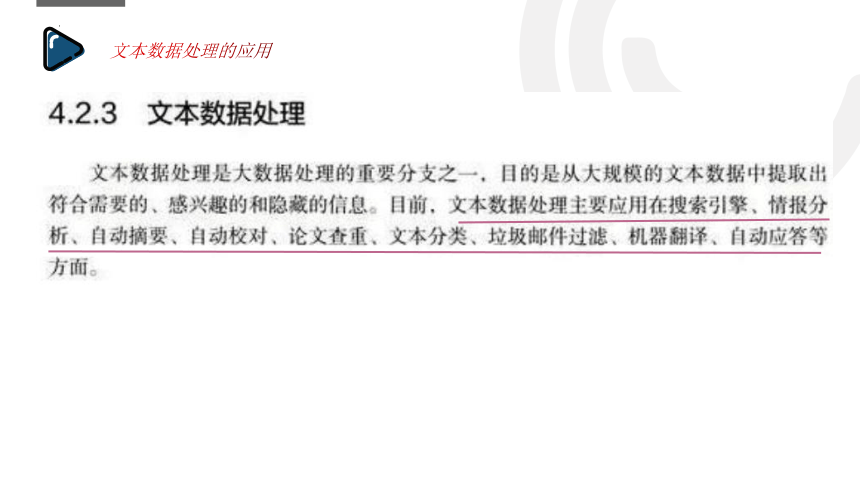

论文查重

垃圾邮件过滤

非结构化数据

结构化:

缺一不可

采集信息

One day your teacher,day day your father

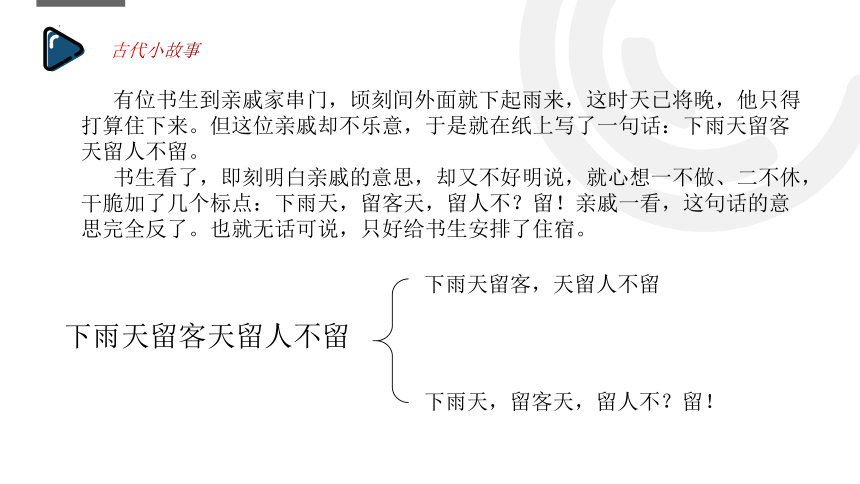

古代小故事

有位书生到亲戚家串门,顷刻间外面就下起雨来,这时天已将晚,他只得打算住下来。但这位亲戚却不乐意,于是就在纸上写了一句话:下雨天留客天留人不留。

书生看了,即刻明白亲戚的意思,却又不好明说,就心想一不做、二不休,干脆加了几个标点:下雨天,留客天,留人不?留!亲戚一看,这句话的意思完全反了。也就无话可说,只好给书生安排了住宿。

下雨天留客天留人不留

下雨天留客,天留人不留

下雨天,留客天,留人不?留!

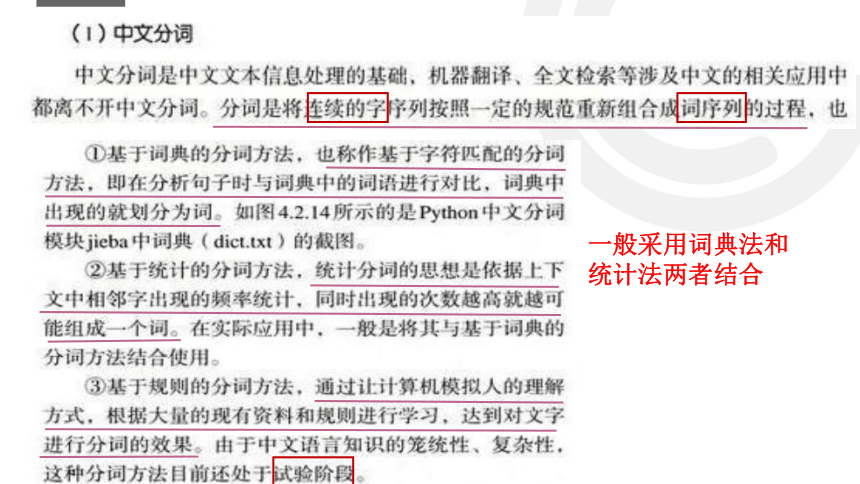

中文分词

一般采用词典法和统计法两者结合

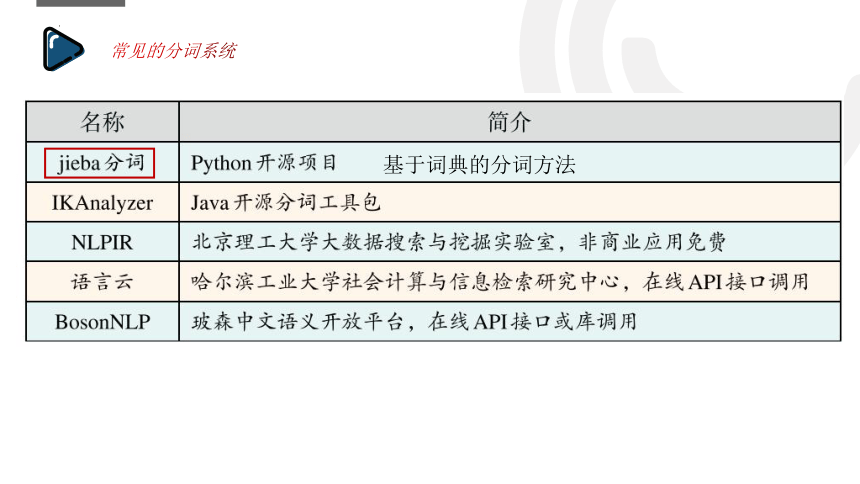

常见的分词系统

基于词典的分词方法

file=”英文文本分析.txt”

text=open(file).read() #读取文件

words=text.split()

#把每一行按照空格分词,变成列表

print(words)

输出:[“red” , ”apple”]

file=”英文文本分析.txt”

text=open(file).read()

for line in text: #获取每一行

print(words)

输出:[“red” , ”apple”]

[“The” , ”apple” , ”is”,”red”]

words=line.split()

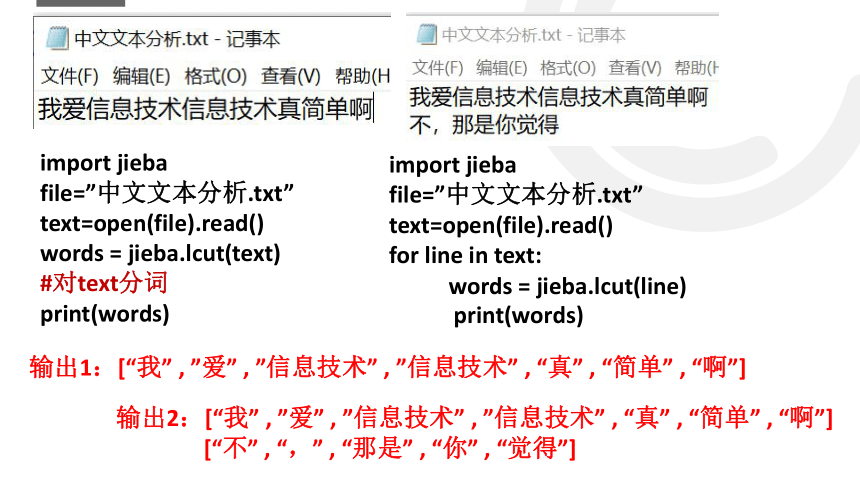

jieba实例

输出1:[“我” , ”爱” , ”信息技术” , ”信息技术” , “真” , “简单” , “啊”]

import jieba

file=”中文文本分析.txt”

text=open(file).read()

words = jieba.lcut(text)

#对text分词

print(words)

import jieba

file=”中文文本分析.txt”

text=open(file).read()

for line in text:

print(words)

输出2:[“我” , ”爱” , ”信息技术” , ”信息技术” , “真” , “简单” , “啊”]

[“不” , “,” , “那是” , “你” , “觉得”]

words = jieba.lcut(line)

jieba实例

import jieba

sentence=input('输入文本∶')

sent=jieba.lcut(sentence)

for cy in sent :

print(cy)

import jieba

sentence=input('输入文本∶')

sent=jieba.lcut(sentence)

for cy in sent[::-1] :

print(cy)

import jieba

sentence=input('输入文本∶')

sent=jieba.lcut(sentence)

count = 0

for cy in sent :

if len(cy)>=2:

count = count+1

print(count)

import jieba

sentence=input('输入文本∶')

sent=jieba.lcut(sentence)

count = {}

for cy in sent :

if len(cy)>=2:

if cy in count:

count[cy]=count[cy]+1

else:

count[cy]=1

print(count)

计算分词后的词语数(至少2字)

统计分词后的词语(至少2字)及其数量

特征提取

表达文章的信息,区分文章的不同

特征提取的方式

①

②

文本数据分析与应用

数据分析:标签云

词云

文本可视化

数据分析:文本情感分析

情感分析:

这城市那么空,

这回忆那么凶,

这街道车水马龙,

我能和谁相拥

数据分析:文本情感分析

小结

文本数据处理的主要应用有( )

①搜索引擎 ②自动摘要 ③论文查重 ④列车查询 ⑤微博评论典型意见

A.①④⑤ B.①②③⑤

C.②③④ D.②③④⑤

B

练习

Python中文分词模块jieba采用的分词方法属于

A.基于词典 B.基于统计

C.基于规则 D.以上都有可能

A

练习

构造评估函数的特征提取法大多是基于( )设计的

A.语义分析

B.情感分析

C.概率统计

D.专家知识

C

练习

下列关于文本数据处理的说法,正确的是( )

A.处理的文本信息通常是结构化数据

B.特征提取是中文文本信息处理的基础

C.目前的分词算法能实现完全准确的进行分词

D.处理的目的是从大规模的文本数据中提取出符合需要的有用模式和隐藏的信息

D

练习

练习

C

下列选项中不属于文本情感分析主要应用场景的是( )

A.网络舆情监控 B.用户评论

C.分析与决策 D.统计字词的频度

D

练习

在网上搜索朱自清的《绿》文章,如图所示。

(1)搜索的信息并保存为txt文件,该过程称为________________。

(2)“绿.txt”文件是文本的类型是________。

(填字母:A.结构化数据/B.半结构化数据/C.非结构化数据)

B

import collections

import jieba

import wordcloud as wc

import numpy as np

from PIL import Image

wcg=wc.WordCloud(background_color=″white″,font_path='assets/msyh.ttf')

text=open('data/绿.txt',encoding='utf-8').read()

seg_list=______①______

f=collections.Counter(seg_list)

wcg.fit_words(f)

wcg.to_file('output/b.png')

划线处①语句是调用jieba对象的cut函数对变量为text文件进行分词,则该处语句为________________。

B

(4)得到的云标签如图所示。

该图片的文件名是________,表示该文本特征是________________(至少写出3个)。

B

文本数据处理

百度搜索:信息技术难不难?

文

本

数

据

处

理

文本数据处理的应用

论文查重

垃圾邮件过滤

非结构化数据

结构化:

缺一不可

采集信息

One day your teacher,day day your father

古代小故事

有位书生到亲戚家串门,顷刻间外面就下起雨来,这时天已将晚,他只得打算住下来。但这位亲戚却不乐意,于是就在纸上写了一句话:下雨天留客天留人不留。

书生看了,即刻明白亲戚的意思,却又不好明说,就心想一不做、二不休,干脆加了几个标点:下雨天,留客天,留人不?留!亲戚一看,这句话的意思完全反了。也就无话可说,只好给书生安排了住宿。

下雨天留客天留人不留

下雨天留客,天留人不留

下雨天,留客天,留人不?留!

中文分词

一般采用词典法和统计法两者结合

常见的分词系统

基于词典的分词方法

file=”英文文本分析.txt”

text=open(file).read() #读取文件

words=text.split()

#把每一行按照空格分词,变成列表

print(words)

输出:[“red” , ”apple”]

file=”英文文本分析.txt”

text=open(file).read()

for line in text: #获取每一行

print(words)

输出:[“red” , ”apple”]

[“The” , ”apple” , ”is”,”red”]

words=line.split()

jieba实例

输出1:[“我” , ”爱” , ”信息技术” , ”信息技术” , “真” , “简单” , “啊”]

import jieba

file=”中文文本分析.txt”

text=open(file).read()

words = jieba.lcut(text)

#对text分词

print(words)

import jieba

file=”中文文本分析.txt”

text=open(file).read()

for line in text:

print(words)

输出2:[“我” , ”爱” , ”信息技术” , ”信息技术” , “真” , “简单” , “啊”]

[“不” , “,” , “那是” , “你” , “觉得”]

words = jieba.lcut(line)

jieba实例

import jieba

sentence=input('输入文本∶')

sent=jieba.lcut(sentence)

for cy in sent :

print(cy)

import jieba

sentence=input('输入文本∶')

sent=jieba.lcut(sentence)

for cy in sent[::-1] :

print(cy)

import jieba

sentence=input('输入文本∶')

sent=jieba.lcut(sentence)

count = 0

for cy in sent :

if len(cy)>=2:

count = count+1

print(count)

import jieba

sentence=input('输入文本∶')

sent=jieba.lcut(sentence)

count = {}

for cy in sent :

if len(cy)>=2:

if cy in count:

count[cy]=count[cy]+1

else:

count[cy]=1

print(count)

计算分词后的词语数(至少2字)

统计分词后的词语(至少2字)及其数量

特征提取

表达文章的信息,区分文章的不同

特征提取的方式

①

②

文本数据分析与应用

数据分析:标签云

词云

文本可视化

数据分析:文本情感分析

情感分析:

这城市那么空,

这回忆那么凶,

这街道车水马龙,

我能和谁相拥

数据分析:文本情感分析

小结

文本数据处理的主要应用有( )

①搜索引擎 ②自动摘要 ③论文查重 ④列车查询 ⑤微博评论典型意见

A.①④⑤ B.①②③⑤

C.②③④ D.②③④⑤

B

练习

Python中文分词模块jieba采用的分词方法属于

A.基于词典 B.基于统计

C.基于规则 D.以上都有可能

A

练习

构造评估函数的特征提取法大多是基于( )设计的

A.语义分析

B.情感分析

C.概率统计

D.专家知识

C

练习

下列关于文本数据处理的说法,正确的是( )

A.处理的文本信息通常是结构化数据

B.特征提取是中文文本信息处理的基础

C.目前的分词算法能实现完全准确的进行分词

D.处理的目的是从大规模的文本数据中提取出符合需要的有用模式和隐藏的信息

D

练习

练习

C

下列选项中不属于文本情感分析主要应用场景的是( )

A.网络舆情监控 B.用户评论

C.分析与决策 D.统计字词的频度

D

练习

在网上搜索朱自清的《绿》文章,如图所示。

(1)搜索的信息并保存为txt文件,该过程称为________________。

(2)“绿.txt”文件是文本的类型是________。

(填字母:A.结构化数据/B.半结构化数据/C.非结构化数据)

B

import collections

import jieba

import wordcloud as wc

import numpy as np

from PIL import Image

wcg=wc.WordCloud(background_color=″white″,font_path='assets/msyh.ttf')

text=open('data/绿.txt',encoding='utf-8').read()

seg_list=______①______

f=collections.Counter(seg_list)

wcg.fit_words(f)

wcg.to_file('output/b.png')

划线处①语句是调用jieba对象的cut函数对变量为text文件进行分词,则该处语句为________________。

B

(4)得到的云标签如图所示。

该图片的文件名是________,表示该文本特征是________________(至少写出3个)。

B